“要有光!”——但这回不是神话,而是美国国防部顶级研究机构DARPA正在推动的一场计算革命。

DARPA最近启动了一项名为PICASSO(可扩展系统目标的光子集成电路架构)的前沿计划,豪掷约3500万美元(约2.5亿人民币),召集全球科研高手,目标直指:突破物理定律的束缚,造出真正能打的光子计算机,大幅提升人工智能的性能!

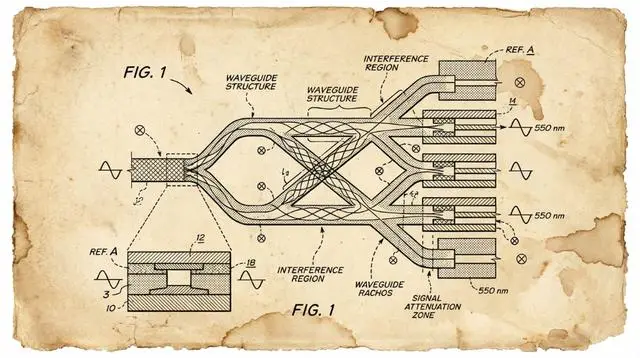

这不是小打小闹的实验室玩具。DARPA想要的是将光子计算从目前“功能狭窄”的演示阶段推向大规模实用,用光代替电子进行运算,从根本上突破现有芯片的算力与能效天花板。

光子计算,强在哪?

简单说,就是用光(光子)而非电(电子)来传输和处理数据。它的先天优势太诱人:带宽超大、延迟超低、能耗还更少,简直就是为AI训练、高性能计算这些“算力吞金兽”量身定做的未来技术。事实上,一些基础的光子电路已经存在。

那为啥还没普及?物理学“拦路虎”出现了。

DARPA直接点出两大难题:

-

信号“衰减”没法整:光信号在传输中会减弱,而且自带噪声。要放大信号?噪声也跟着一起放大,纯纯的“按下葫芦浮起瓢”。

-

光波“乱窜”太头疼:杂散光会引起散射、反射、串扰等各种干扰。组件一多,误差控制就变得极其不可预测,再叠加上制造偏差和温度变化,工程难度爆炸。

结果就是,现在的光子电路规模小、功能单一(大多只能做简单的线性运算),而且不得不在系统里频繁进行“光-电-光”转换。一转换,光的速度优势(纳秒级)就被电子电路的毫秒级延迟拖垮,性能直接掉6个数量级——等于白干。

DARPA:别等新零件,用“神布局”打败物理!

DARPA的思路很清晰:不等颠覆性的新组件发明,就用现有的光子“积木”,通过颠覆性的电路架构设计来化解根本性物理限制。

这就像当年电子电路,通过精妙的电路设计克服了单个晶体管的局限。PICASSO项目就是要激发这种“电路级”的创新,让光子芯片实现前所未有的性能和稳定性。

项目节奏与“支票”已到位:

-

总资金:约3500万美元,将分给多个中标团队。

-

第一阶段(18个月):展示光子电路的可预测性能。

-

第二阶段(再18个月):演示更广泛的电路功能。

-

提案截止日:2025年3月6日。这场光与电的赛跑,已经发令。